Befasse sie damit nicht!

1) Exakte Zahlen errechnen

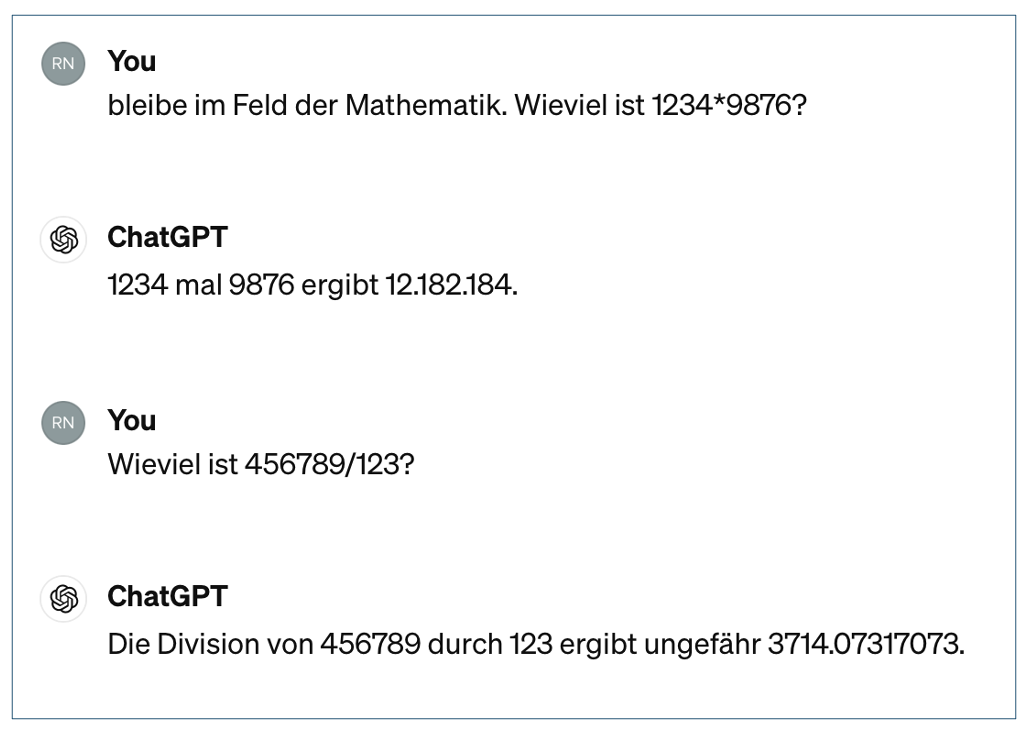

Zwei Beispiele zum Multiplizieren und Dividieren ergaben im ersten Versuch folgende Ergebnisse:

Die Multiplikation ist falsch. Das richtige Ergebnis lautet 12.186.984, also um fast 5.000 daneben.

Dagegen führt die Division nicht sofort in tiefen Abgrund. Das richtige Ergebnis lautet 3.713,73. Es weicht also hinsichtlich von zwei Nachkommastellen um 34 Hunderstel vom Ergebnis ab.

GPT4 führt hier einen Eiertanz auf: Erstens schreibt es richtigerweise von "ungefähr", aber bietet dann eine Zahl mit acht Nachkommastellen an. Man nennt das in der Statistik false precision oder fake precision. Eine bestimmte Genauigkeit vortäuschende Präzision führt in die Irre.

Dies kommt nicht selten in wissenschaftlichen Veröffentlichungen vor. Wenn bei 70 erhobenen Datensätzen beispielsweise für ein deskriptives Ergebnis 23,6% angeben wird. Eine solche standardisierende Promille-Angabe (Pro-Mille, also je Tausend) wäre eigentlich erst im vierstelligen Bereich von Datensätzen berechtigt.

Fazit: Simple Taschenrechner können das besser.

2) Frequenzen erheben

Wie zum Beispiel die Anzahl des Wortes „und“ in einem Text zählen. Ein eingegebener deutscher Beispieltext von insgesamt 3.236 Wörtern enthält das Wort „und“ 116 Mal.

GPT4 meint dagegen, es seien 122.

Fazit: Simple Texteditoren können das besser.

3) Zitieren und Zitate suchen

Angenommen, du hast zu offenen Fragen spontane Aussagen von 700 Personen. Diese Aussagen werden in der weiteren Analyse in Kategorien unterteilt. Wenn du nun nach bestimmten Aussagen suchst, wirst du ein blaues Wunder erleben. Dies gilt auch dann, wenn du ausdrücklich darauf hinweist, dass du Originalaussagen präsentiert haben willst.

- Vergleichsweise harmlos ist das erste Beispiel: Aus der Originalaussage "1 Kind" wird "Ein Kind".

- Schon deutlich abweichender ist das zweite Beispiel: Aus der Originalaussage "Auch die Lehrkräfte waren" wird "Die Lehrer:innen waren". Überdies fehlt das "Auch", wodurch es zu Sinnveränderungen kommt. Ebenso verändernt GPT die unzulässigerweise die Aussage, indem er meint, gendern zu müssen.

Ein schwerwiegende Fehler entsteht aber aus der Tatsache, dass GPT4 – angabenwidrig – Zusammenfassungen mehrerer Originalaussagen macht und als eine (!) Originalaussage präsentiert.

Fazit: Vieles sieht man nicht sofort (daher alles, aber auch wirklich alles checken!), manches ist als Zusammenfassung sofort zu erkennen. Wenn zum Beispiel nach der Situation in der einzelnen jeweiligen Familie während der Corona-Pandemie gefragt wurde, aber als "Originalaussage" präsentiert wird: "Einige Familien erlebten [...]", dann weißt du, dass du diese Aussage im eingegebenen Text nicht finden wirst. Sie ist schlicht falsch.

4) Die KI soll etwas Spezifisches finden – vertraue dem nicht

Das Gesuchte ist möglicherweise NICHT im Text vorhanden .

Fazit: Simple Texteditoren oder Spreadsheets wie Excel können das besser.

5) Die KI soll bestätigen, dass etwas Spezifisches nicht vorhanden ist – vertraue dem nicht

Das Gesuchte kann DENNOCH im Text vorhanden sein .

Fazit: Simple Texteditoren oder Spreadsheets wie Excel können das besser.

15. Mai 2024

Die Fehler-Bugs lauern überall