Die folgenden Essays zur Künstlichen Intelligenz (Artificial Intelligence oder maschinelles Lernen) mögen aufzeigen, wie die textgenerativen KI-Programme unsere Bildungssysteme verändern.

PS: Zu den Kommentaren bitte den Beitragstitel angeben. :-)

Das ökonomische Prinzip funktioniert nicht mehr (1)

Wie im vorigen (untenstehenden) Blog-Beitrag aufgezeigt, haben Verantwortlichen in und für Universitäten sparorientiert im Laufe der Jahrzehnte das ökonomische Prinzip in seiner Minimalformulierung angewendet: „Biete die beauftragte Lehre mit dem geringstmöglichen Aufwand an“.

Einen Schwerpunkt auf schriftliche Arbeiten zu setzen, hat konsequenterweise zu einer Transformation der Lehre geführt: Weg von einer tiefgreifenden, inhaltlichen und methodischen Bildung hin zu einem Fokus auf den formalen akademischen Abschluss.

Welche Überraschung – die gelehrigen Studierenden wenden nun ihrerseits das ökonomische Prinzip an! Ebenso in der Minimalform, gelehrt ist eben gelernt. ;-) Dies zeigt sich exemplarisch an den textgenerierenden KI-Systemen wie ChatGPT. Diese Technologie hat das mühsame Recherchieren, Sichten und Zusammenfassen von Literatur extrem vereinfacht. Es führt so zu einer Minimierung von Arbeitsaufwand und – leider auch – geistiger Anstrengung.

Anders gesehen: ChatGPT wird von den Studierenden genutzt, um gegen die langjährigen Schwächen in der Lehre an Universitäten anzukämpfen. ChatGPT ermöglicht, schnell zu den gewünschten formalen und schriftlichen Ergebnissen zu kommen, die den universitären Anforderungen entsprechen.

Mitten im Studentenviertel: Der Campo Santa Margherita in Venedig

Was tun? Um sicherzustellen, dass Studierende wirklich lernen und nicht nur KI-generierte Texte einreichen, könnten Universitäten verschiedene Methoden anwenden. Dazu gehören überwachte Klausuren ohne Zugang zu generativen KI-Systemen oder im Gegenteil Klausuren, in denen der KI-Einsatz erwünscht ist.

Diese zweite Alternative würde die Studierenden ertüchtigen, kompetent mit KI umzugehen, um bessere Ergebnisse zu erhalten. Angesichts der wachsenden Bedeutung von KI in der Arbeitswelt und in der wissenschaftlichen Forschung wäre dies ein wichtiger didaktisch-pädagogischer Schritt. Ertüchtigen aber nur dann, wenn eine Reflexion des KI-Einsatzes durch die Studierenden geschieht. Und wer bewertet das?

All das erfordert einen deutlich höheren Bedarf an universitärem Personal, ob Professoren oder Lektoren. Man braucht mehr Lehrkräfte für die Überwachung von Klausuren oder für kleinere, dafür persönlichere Seminare. Gleiches gilt für die individueller werdenden Bewertungen von studentischen Leistungen.

Andere Methoden, wie detaillierte Forschungsprotokolle mit zeitgerecht gespeicherten Datenquellen, Analysen und Schlussfolgerungen, könnten ebenfalls dazu beitragen, den Missbrauch von KI zu verhindern. Aber auch hier wird ein größerer Einsatz von universitärem HR, den human ressources unabdingbar sein.

--> So wird ein großer Schritt zurück zum urspünglichen universitas-Gedanken stattfinden:

Besser lehren und lernen innerhalb eines persönlichen Rahmens!

30. Dezember 2023

Das ökonomische Prinzip funktioniert nicht mehr (2)

Im letzten halben Jahrhundert haben Universitäten und Hochschulen einen beispiellosen Aufschwung erlebt. Möglichst viele wollen einen akademischen Abschluss erwerben. Finanzielle Mittel wurden nicht entsprechend gesteigert.

Ökonomische Maßnahmen, die darauf abzielen, den Massenansturm zu bewältigen, führen aber zu Folgen wie

- ... einem Erschweren des Zugangs. Dadurch werden oft potenziell geeignete Studienbewerber ausgeschlossen. In den Eingangsphasen werden regelmäßig Massenprüfungen mittels Multiple-Choice-Fragebogen durchgeführt. Klar, diese sind computergestützt einfach auszuwerten. Doch sind es gerade diese Umstände, die die Charakteristika des jeweiligen Faches verschleiern und die Studierenden demotivieren.

- ... einem abstrakten und formal-nominal orientierten Prozess des Wissenserwerbs und des Prüfens. Dies behindert und beschränkt eine breite Bildung der Studierenden.

- ... einem stetig unpersönlicher werdenden Verhältnis von Studierenden und Vortragenden. Der direkt motivierende Zugang zum jeweiligen Fach ist mühsamer geworden.

- ... einem Bevorzugen von Lehrenden, die Drittmittel, also externe finanzielle Mittel einwerben. Dadurch kommt es zu einem verzerrten Prozess des Forschens. Selten sind diese Drittmittel philanthropisch, also rein menschenliebend und uneigennützig gedacht. Forschungsziele werden andere, Ergebnisse bilden nur mehr bedingt das Forschungsobjekt ab.

- ... einem In-den-Vordergrund-Rücken von schriftlichen Arbeiten, seien es Haus-, Seminar- oder Abschlussarbeiten. Mit wenig Betreuungs- und Begutachtungsaufwand kann so das Denken der Studierenden dokumentiert und überprüft werden. Manchmal können so innerhalb weniger Stunden Diplom- und Masterarbeiten eingesehen und bewertet werden, für die der Studierende zu Hause einen Aufwand von einem halben bis zu einem ganzen Jahr in Vollzeit benötigt hatte.

Fast alle genannten Punkte stellen das ursprüngliche Prinzip der universitas auf den Kopf. Universitas ist das wesentliche und namengebende Kennzeichen der europäischen Uni-Gründungen ab dem 12. Jahrhundert. Das Prinzip verweist auf die Einheit von Wissenserwerb und Wissensweitergabe unter Lehrenden und Lernenden.

Es geht um gegenseitigen Schutz und Hilfe innerhalb eines eigenen Rechtsbereiches. Für diesen wechselseitige Schutz auf Augenhöhe ("wir sind eins") ist es unerheblich, ob die Treffen innerhalb eines Gebäudes oder eines Campus oder in den Privaträumen der Gelehrten geschehen, wie häufig im Mittelalter der Fall ist. Magistri und Studiosi bilden als überschaubare Gruppe eine auf Autonomie gerichtete Genossenschaft.1

Die heutige Universität ist eine andere geworden. Sie hat zu erheblichen Teilen das Prinzip der universitas ausgelagert.

Aus persönlicher und sprachlich kommunikativer Nähe und Interaktionen aller Beteiligten wird ein isoliert ausgetragener K(r)ampf der Studierenden auf Basis gedruckter Schriften und Bildschirme.

Die kollektiven Akteure in den heutigen Universitäten sollten sich warm anziehen,

denn die textgenerierende KI

wird diese Auslagerung ad absurdum führen.

23. Dezember 2023

1 Borgolte, Michael (2015). Sozialformen wissenschaftlicher Autonomie im Mittelalter – und darüber hinaus. In: Autonomien der Wissenschaft? : Streitgespräche in der Wissenschaftlichen Sitzung der Versammlung der Berlin-Brandenburgischen Akademie der Wissenschaften am 28. November 2014. Berlin, S. 12-20

Hypertext = Old School im Internet

Wer üblicherweise im Netz etwas sucht, ist auf das Auffinden eines passenden Hypertextes angewiesen. Google hilft dabei und bietet Hypertexte (oder einfach gesagt: Links) an, die nach der von Google errechneten Wichtigkeit gereiht sind.

Du klickst auf einen der ersten zwei oder drei Optionen, und schon erscheint die verlinkte Website am Schirm, falls sie denn online ist.

Dann findest du im Idealfall nach einigem Navigieren die gesuchte Information. Aber oft ist die Information mittels weiterer Seiten zu vervollständigen. Und selbstverständlich, lesen und die entsprechenden Wissenspartikel herausklauben und verstehen musst du selber.

HyperHypertext = New School im Internet

KI ändert das alles. Suchst du etwas, so wird eine Frage eingetippt. Eine ausformulierte Antwort, bestehend aus vollständigen und formal elegant geschriebenen Sätzen erscheint am Schirm. So bei ChatGPT. Das alles in natürlicher und menschentypischen Sprache. Wie komfortabel, wie bequem! Die mühevolle Suche und das Zusammenstellen wird einem abgenommen.

Ein Check bleibt: Passt die angebotene Information, ist sie treffsicher und entspricht sie der Realität? Gerne sind die Antworten allgemein, aber häufig durchaus konkret und plausibel, vielleicht sogar völlig ok.

ChatGPT kann dies, weil das Programm zuvor Abermillionen von Texten durchsucht, gestückelt, organisiert und die unzähligen Texteinheiten quasi in einer Box gespeichert hat.

--> Den einfachen Hypertext gibt es nun nicht mehr, denn er wurde von der KI vorab geschluckt und verdaut.

Es gilt wie immer, die Inhalte zu prüfen und die Quellen zu hinterfragen. Wenn die Quellen doch nur angegeben wären! Sie sind es derzeit in der Regel nicht. Bei vielen Antworten erweisen sich die angegebenen Internet-Links überdies als irreführend.

Man weiß, man muss es überprüfen. Sogar ChatGPT schreibt fürsorglich und absichernd, man möge dies tun. Allein, wir machen es selten.

Die Evolution hat uns mit einem Gehirn ausgestattet, das viel Energie braucht. Wir sparen zusätzliche, vielleicht gar nicht notwendige Arbeit ein. Also wird die KI-Antwort mit dem Gefühl „Es wird schon im Großen und Ganzen richtig sein“ angesehen und übernommen.

Wir üben nun kaum mehr das strukturierte Suchen und die damit verbundene implizite Prüfung des Gehalts und der Qualität der Quellen. Wir verlernen es. Die Zeit wird zeigen, wie wir Menschen damit umgehen.

14. Dezember 2023

PS: Dieser Text wurde mittels ChatGPT 4 auf orthografische und grammatikalische Fehler überprüft. Wenn noch welche drinnen sein sollten, ist ChatGPT schuld! :-). Oder doch nicht?

PPS: Hab noch einiges im obigen Text nach der Korrektur durch ChatGPT verändert und umgestellt. Spröde Formulierungen und neu eingeschlichene Fehler bleiben am Autor hängen. :-(

Vorsicht, Löwe!

Chat-GPT hat Mitte 2023 die 100-Millionen-Nutzergrenze durchbrochen. Es ist kein Wunder, dass nach Schätzungen neun von zehn Studierenden Chat-GPT oder ähnliche KI-Programme nutzen. Und die Unis, Hochschulen und akademischen Lehrgänge?

Sie wissen nicht, wie sie damit umgehen sollen und stecken als Organisation den Kopf in den Sand.

Sie überlassen es meist einzelnen Seminarleitern oder Betreuern, geeignet zu reagieren. Diese aber sind hiervon überfordert. Klar, es liegt nicht in ihrer Verantwortung und sie verfügen nur teilweise über geeignete Instrumente wie etwa das Plagiatsprogramm Turnitin, das einen Wahrscheinlichkeitswert für die Verwendung von KI ausspuckt.

Alles so laufen lassen wie bisher? Nein, das geht nicht. KI ist eine disruptive Innovation, wie die Ökonomen sagen.

Zerstörend. Das so schön gesponnene und austarierte Netz von Lehren, Lernen, mündlichen Prüfungen oder schriftlichen Arbeiten ist perdu.

Vor den Unis liegt Neuland. Hic sunt leones, wie die Kartografen vor einem halben Jahrtausend in Karten über Afrika geschrieben hatten, wenn es keine Informationen zu einem Gebiet gab. Hier gibt es Löwen: Ja, das passt als Metapher für einen umsichtigen Umgang mit KI.

Eine Geschichte wurde mir vor kurzem erzählt, in der ein Löwe einen fröhlichen Fast-Master >tötete<. Alle Prüfungen an einer Privat-Uni geschafft, lud er (ich gendere nicht) nach einem zweiwöchigen entspannten Strandurlaub zufrieden eine ausgewogene Masterthese hoch.

Jedoch erhielt er bald eingeschriebene Post: wegen versuchten Betruges von der Universität exmatrikuliert, Prüfungen aberkannt, Gebühren verloren und Studienabschluss samt akademischem Grad außer Reichweite. Ein Plagiats- und KI-Bestimmungsprogramm hatte angeschlagen.

Klar hätte er nun mittels Vorversionen der eingereichten Masterthese seine Autorenschaft belegen und Recherchen samt Daten, vollständigem Forschungsprotokoll etc. vorlegen können, denn die Beweislast für die Urheberschaft einer Forschungsarbeit liegt beim Bewerber.

Das konnte er nicht – war doch zu bequem gewesen.

29. September 2023

Künstliche Intelligenz kann Intelligenz?

KI ahmt die Abläufe im Gehirn nach, daher seien die Ergebnisse so überzeugend – so die Hintergrundannahme der zahlreichen Veröffentlichungen, wenn über die zugrunde liegenden Algorithmen von KI geschrieben wird.

KI setzt auf neuronalen Netzen auf, also Nervenzellen, die miteinander in einem Netzwerk verbunden sind. Vieles jedoch wird in dieser oberflächlichen Sicht übersehen.

Die ursprüngliche Annahme, dass definierte Funktionen wie das Sehen oder Hören in spezifisch geschalteten Teilen dieses Netzwerks (des Gehirns) ablaufen, gilt schon lange nicht mehr.

Vermutlich ist das noch nicht bis zu den KI-Designern durchgedrungen. Sie setzen darauf, dass KI auf Basis von Chips, mathematischen Algorithmen und Trainingsdaten die biologische Vernetzung von Neuronen und spezifischen Gebieten simuliert.

Der komplexe Aufbau des Gehirns

Das menschliche Gehirn funktioniert viel komplexer als ein Verbund von Neuronen. Unser Wissen über das Gehirn ist vergleichbar mit dem Zehntel eines Eisberges, der aus dem Wasser ragt. Wir kennen noch sehr wenig von den Vorgängen im Gehirn und stehen vor der schwierigsten wissenschaftlichen Frage überhaupt: Was ist Bewusstsein? Was wir bisher wissen, zeigt, dass die direkte Verbindung von Nervenzelle zu Nervenzelle nur einen Teil der Wahrheit darstellt.

Organoide als Forschungsinstrumente

Die biologische Gehirnforschung hat neue Wege eingeschlagen, um mehr darüber zu erfahren. Ein vielversprechender Ansatz ist die Verwendung von Organoiden (1), miniaturisierten Gehirnmodellen, die aus menschlichen Stammzellen gewonnen werden.

Diese organähnlichen Nervengebilde entwickeln sich selbstorganisierend und ermöglichen es den Forschern, die Bildung bestimmter Gehirnstrukturen und -funktionen zu beobachten.

Interessanterweise zeigen diese Miniatur-Gehirne eine drahtlose Verbindung zwischen Zellen, selbst über weit entfernte Areale hinweg. Dies geschieht durch oszillierende Schwingungen mit unterschiedlichen Amplituden.

Die drahtlosen Verbindungen in den Organoiden ähneln in gewisser Weise der Funktechnologie, die bereits seit über einem Jahrhundert bekannt ist und beispielsweise in Mobiltelefonen zum Einsatz kommt.

Die Rolle von Schwingungen und Frequenzen

Ein hilfreiches Bild zur Veranschaulichung dieses Phänomens ist die Vorstellung, dass verschiedene Bereiche von Nervenzellen in den Organoiden wie Instrumente eines Orchesters agieren. Sie synchronisieren sich gegenseitig über Feedback-Schleifen und übertragen Informationen.

Kommunikation könnte auf Kohärenz beruhen, also einem Zusammenhang, der den gleichen Sinn im Fokus hat (2). Diese Art eines präzisen und selektiven Informationsaustauschs ähnelt einer Art Bluetooth-Verbindung im Gehirn.

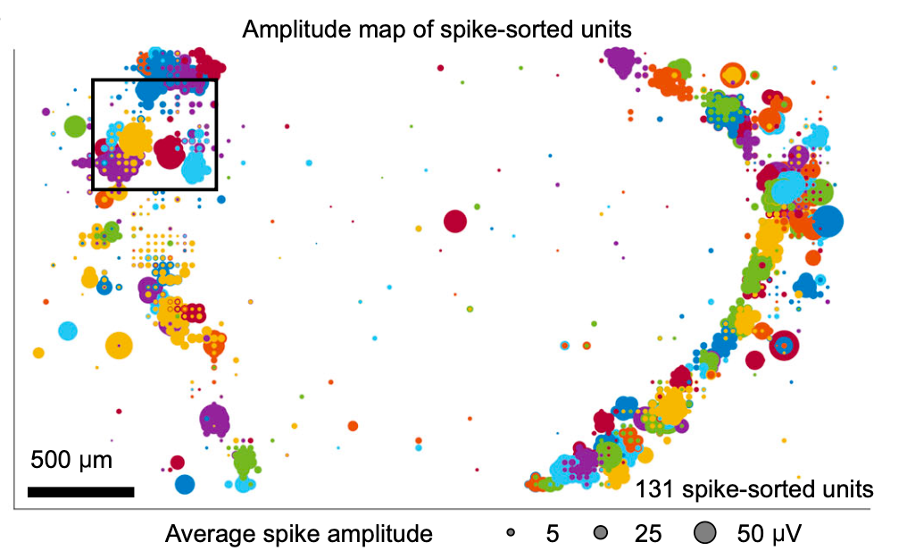

Eine Abbildung eines Querschnitts aus einem Gehirn-Organoid verdeutlicht die "funkverbundenen" Neuronencluster mit gleichen Amplituden.

Querschnitt-Karte von Neuronencluster mit gleichen Amplituden in einem dreidimensionalen Organoid eines Teilmodells des menschlichen Gehirns. Ausgelesene 1020 Top-Elektroden auf Basis von 24.600 angebrachten Mini-Elektroden insgesamt. Quelle: (3)

Unser Gehirn gleicht einer Kombination aus Theater und Konzertsaal, nur dass die Zuschauer mitspielen und die Musikanten verteilt im Zuhörerraum sitzen. Ein Geiger sitzt links, ein anderer rechts, ein Chellospieler vorne, zwei hinten. Die Musikanten fordern einander auf und spielen miteinander. Sie synchronisieren ihre Rhythmen und spielen langsame oder rasche, lustige oder traurige Melodien.

Die Zuhörer und gleichzeitigen Schauspieler zwischen den Musikanten halten die Hände ihrer Nachbarn erzählen einander Geschichten. Sie erzählen einander von Szenen in der sogenannten Außenwelt, die den Schattengestalten von Platons Höhlengleichnis ähneln.

Die Neuronen flüstern bei langsamen Klängen der Musikanten, erzählen von Unbekanntem oder schreien, falls die Trommler von existenziell bedrohenden Nachrichten aus der Außenwelt verkünden. Echte emotionale verflochtene Intelligenz eben. Das Gehirn gleicht somit einer symbiotischen Zusammenarbeit von Musikanten und Zuschauern in einem Musiktheater.

Die Grenzen der aktuellen KI-Programme

Die derzeitigen KI-Programme basieren hauptsächlich auf der Nachbildung von Verbindungen und Funktionen neuronaler Netze. Sie sind jedoch nicht in der Lage, Informationen über oszillierende Schwingungen drahtlos zu übertragen, wie es im menschlichen Gehirn der Fall ist. Aus diesem Grund sind sie bestenfalls eine halbe Künstliche Intelligenz.

Um wahre Künstliche Intelligenz zu erreichen, müssen wir einen fundamental anderen Ansatz verfolgen. Hier könnten Quantencomputer ins Spiel kommen. Schau'n wir mal. :-)

Quantencomputer als Mit-Zukunft echter Künstlicher Intelligenz?

Die Entwicklung von Quantencomputern verspricht eine revolutionäre Rechen- und Übertragungsart, die eine weitere Grundlage für echte Künstliche Intelligenz sein könnte. Durch die Ausnutzung der Eigenschaften der Quantenphysik können Quantencomputer Informationen parallel verarbeiten und komplexe Berechnungen durchführen, die für herkömmliche Computer unmöglich sind. Quantencomputer simulieren gleichsam die Musikanten des Gehirns.

Ein Verbund aus klassischen Rechnern und Quantencomputern könnte den Weg zu einer ganzen und nicht nur halben Künstlichen Intelligenz ebnen.

(1) Ein Organoid ist eine wenige Millimeter große, organähnliche Mikrostruktur, die mit Methoden der Zellkultur artifiziell erzeugt wird. Sie zeigen physiologisch relevante und organähnliche Eigenschaften; Näheres ist hier zu finden: Organoid-Zellatlas (2021). Nature Biotechnology, Vol. 39, January 2021, S. 13–17; https://www.ncbi.nlm.nih.gov/pmc/articles/PMC7801253/pdf/41587_2020_Article_762.pdf

(2) Fries, P. (2015). Rhythms for cognition: Communication through coherence. Neuron, 88(1), 220-235.

(3) Sharf, T./van der Molen, T./Glasauer, S./ Guzman, E./Buccino A. et al. (2022). Functional neuronal circuitry and oscillatory dynamics in human brain organoids. Nature Communications (2022) 13:4403, S. 2

27. Juni 2023

Chat-GPT oder wie ein verflüssigtes soziotechnische System einen Akteur gebiert

Achtung, Triggerwarnung:Der folgende Text wird etwas theoretisch sein, er kann aber zu einem besseren Verständnis von strukturellen Prozessen und Verschiebungen in Gesellschaften führen. 😉

Wie klar war sie noch vor wenigen Jahren: Die so genannte Schnittstelle, die Verbindung zwischen Mensch und Computer oder zwischen verschiedenen Programmen auf einem Computer oder zwischen verschiedenen Maschinen in einem Netzwerk.

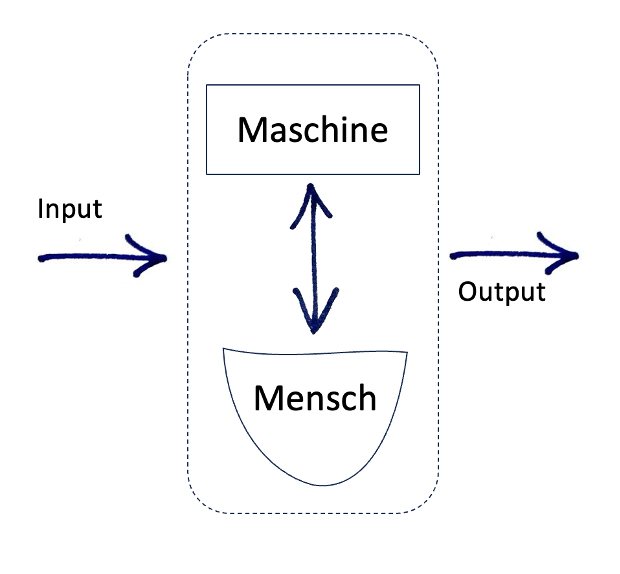

Betrachten wir nur das Modell eines Mensch-Maschine-Systems: Aus einer nicht definierten Umwelt gibt es eine Eingabe (in der Regel in Form einer Aufgabe), die von einem Menschen an eine Maschine in formalisierter Sprache weitergeleitet wird.

Die Maschine erzeugt eine ebenso formalisierte Antwort/Lösung, die als Output in die Umwelt weitergegeben wird, wie in der Abbildung unten dargestellt. Die Anfrage des Menschen an die Maschine musste in einer geeigneten und hochformal strengen Form stattfinden, sonst ‚versteht‘ die Maschine nichts, oder es gibt keinen Output oder noch schlimmer: einen falschen oder unbrauchbaren, der nicht als solcher erkannt wurde.

Die Anfrage des Menschen an die Maschine musste in einer geeigneten und hochformal strengen Form stattfinden, sonst ‚versteht‘ die Maschine nichts, oder es gibt keinen Output oder noch schlimmer: einen falschen oder unbrauchbaren, der nicht als solcher erkannt wurde.

Die Schnittstellen zwischen den Programmen unterschiedlicher Computer hatten es in sich: Formate und Inhalte der Daten mussten adäquat sein. Dies bot im Lauf der letzten Jahrzehnte zig Millionen Programmierern, Designern und Systemanalytikern sichere und gut bezahlte Arbeitsstellen.

Der Funktion der Maschine ist die eines Werk-Zeuges. Werk, die Wortherkunft des ersten Teiles dieser Zusammensetzung von Werk deutet auf wirken, machen, flechten, hervorbringen oder fertigstellen (1). Auf diese Weise wird etwas wirksam und sogar wirklich. Die Wortherkunft von Zeug weist auf ein Gerät oder eine gesamte Ausrüstung. Ein oder mehrere Dinge, die durch Aufwand geschaffen, also gezeugt und geboren werden (2).

Die Zusammensetzung Werkzeug beinhaltet daher einen verketteten Ablauf: Etwas wird geschaffen, um in der Folge damit etwas Weiteres hervorzubringen. Werkzeug im gegenwärtigen Zusammenhang heißt:

Die Maschine wurde geschaffen, um damit durch die Hand des Menschen einen Input aus der Umgebung des Mensch-Maschinen-Systems zu einem Output umzuformen und wieder der Umgebung zuzuführen.

Ja, richtig, viele Worte für einen einfachen Vorgang. Diese modellhafte Auffassung vom Mensch-Maschinen-Schnittstellen-System ist simpel und auch nicht mehr als ein erster Verständnisschritt. Betrachtet man die hohe Zahl an täglich veröffentlichten Artikeln zu einzelnen KI-Themen, fragt man sich, was ist da grundsätzlich los?

Ein Schritt zurück könnte helfen, einen weiteren Horizont zu erhalten – aus einer Modellsicht des Geschehens heißt das vorerst: Welche Elemente oder Faktoren spielen in welchen Interaktionen eine Rolle? Oder: Welche Personen geben aufgrund der gesellschaftlichen Struktur und der entsprechenden Rollen die spezifische Aufgabe einem spezifischen Programm zur Lösung in Auftrag?

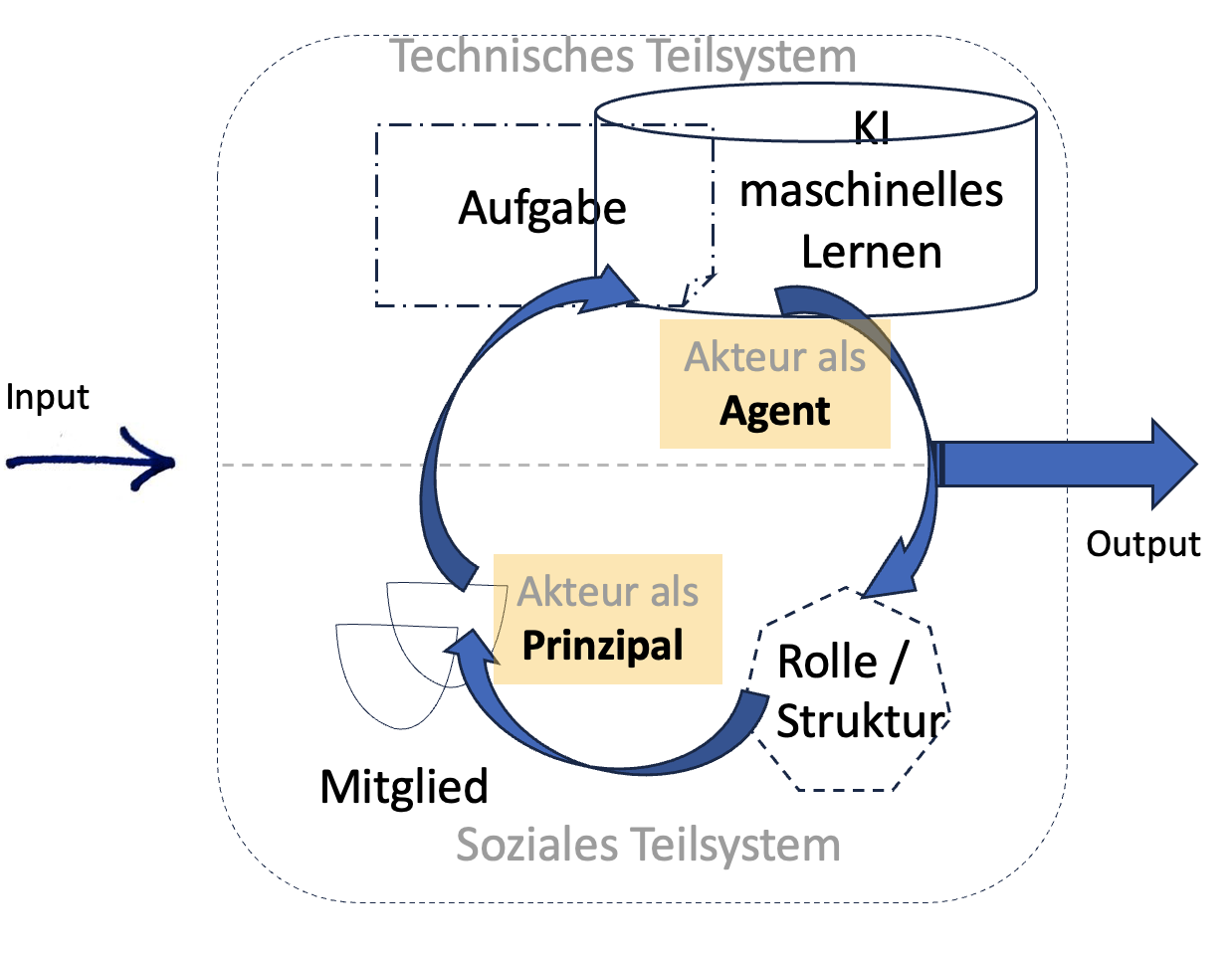

Statt des simplen Schnittstellen-Modells ist differenzierter vorzugehen. Vor zwei Generationen wurde das zentrale Arbeitsmodell eines soziotechnischen Systems entwickelt (4):

Es enthält zwei Teilsysteme, das soziale und das technische Teilsystem. Das technische beruht auf Interaktionen zwischen zwei Komponenten: der Aufgabe und der Technologie. Das soziale beruht auf Interaktionen zwischen Menschen in der jeweiligen vorstrukturierten Rolle. Wie die Pfeile symbolisieren, sind alle Teilkomponenten voneinander abhängig bzw. aufeinander bezogen.

Das soziale Teilsystem kreist um das Selbstverständnis von Personen und Gesellschaft, während im technischen die mechanisch-elektronische Weiterentwicklung im Fokus steht.

Spiegelt dieses nun komplexere Modell die gegenwärtige „Realität“ wider? Vorsicht ist aus wissenschaftstheoretischer Sicht bei den Begriffen Realität oder Wirklichkeit angebracht; sie sind trügerische Konzepte. Denn der berühmte Satz vom britischen Statistiker Box könnte richtig sein: „All models are wrong but some are useful“(3).

Box machte darauf aufmerksam, dass vorab getroffene Annahmen und Ausgangs-Axiome bei den Ergebnissen und deren Interpretationen explizit wieder zu berücksichtigen sind. Er geht aber erfreulicherweise davon aus, dass selbst „realitäts-falsche“ Modelle zu robusten und nützlichen Ergebnissen führen können. Und dies nicht nur in der Statistik, sondern auch in anderen wissenschaftlichen Disziplinen.

Um trotz der rasant ablaufenden KI-Revolution die Modell-Brauchbarkeit zu erhalten, ist etwa zu fragen, welche Schwächen das angeführte soziotechnische Arbeitsmodell hat, die jetzt zum Tragen kommen. Eine zentrale Schwäche ist im Nichtbeachten der Zeit. Während das technische Teilsystem auf Kurzfristigkeit (Minuten, Tage, Wochen, Monate) angelegt ist, beruht das soziale Teilsystem auf Langfristigkeit (Jahre, Jahrzehnte). Gesellschaften und Rollen änderten sich aufgrund von Systembrüchen (Revolutionen, Kriege) oder traditionell in der Abfolge menschlicher Generationen.

Mit anderen Worten, die Brauchbarkeit des soziotechnischen Systemmodells wird durch die KI-Revolution gesenkt, wenn nicht gar zunichte gemacht. Beachtet man die Algorithmen und die Trainingsbasis der Sprachmodelle, sind nun Aufgabe und KI/maschinelles Lernen aufs Engste verknüpft und rekursiv in einem Schleifen-Modus eingespannt.

--> Die Grenzen haben sich aufgelöst. Input und Output sind normal zu lesende Texte geworden. All dies hat fundamentale und rasche Auswirkungen auf die Mitglieder und die Struktur der Gesellschaft.

Aus den fein säuberlich abgegrenzten Elementen und deren Interaktionen des soziotechnischen Systemmodells wird ein flüssiger Wirbel eines systemischen Gesamtgeschehens. Allerdings nun mit einem neuen Akteur!

Beide Teilsysteme sind dynamisch und flüssig geworden. Im sozialen Teilsystem bahnt sich an: Berufsgruppen, welche bisher auf geistiger Routinearbeit beruhte, werde in ihrer Bedeutung abgewertet werden.

Klar abgegrenzte Berufe und Fertigkeiten werden seltener die Schlüsselkompetenz für eine erfüllende und erfolgreiche Existenz werden. Dies wird sowohl für Einzelpersonen, sozial institutionalisierte Gruppierungen als auch für Gesamtgesellschaften im Wettbewerb muntereinander gelten.

Ein gekonnter Umgang mit KI, dem Verstehen dieses neuen Akteurs im Geschehen wird zu einer Schlüsselkompetenz im beruflichen oder privaten Leben. Es dreht sich nun darum, ob der menschliche Akteur den KI-Akteur akzeptiert und vor allem die jeweiligen Stärken und Schwächen aufgrund der fachspezifischen Trainingsdaten und Algorithmen kennt, entsprechend nutzt oder korrigiert.

(1) Kluge (2011). Etymologisches Wörterbuch der deutschen Sprache. 25. Auflage. Berlin: Walter de Gruyter S. 991

(2) Ebd., Kluge, (2011), S. 1008

(3) Sydow, J. (1985). Der soziotechnische Ansatz der Arbeits- und Organisationsgestaltung: Darstellung, Kritik, Weiterentwicklung, Frankfurt am Main: Campus, S. 29

(4) Box, G. (1979). Robustness in the Strategy of Scientific Model Building. In: Launer, R./Wilkinson, G. (ed.): Robustness in Statistics. S. 202)

27. Juni 2023

PS: Erstantworten von KI sind zumeist allgemein und tendenziell oberflächlich. Zu empfehlen ist daher, die KI als eigenständigen Akteur bestenfalls in der Rolle einer Sparringpartnerin anzusehen. Daher mit KI in einen Dialog für mehr Tiefe und zusätzlichen Optionen einzusteigen und – wie nach Brainstorming-Sitzungen üblich – die schlechten "erstürmten Blüten" ausmisten.

PPS: Gemäß der Pinzipal-Agent-Theorie herrscht eine grundsätzlich Macht-Asymmetrie. Der Mensch ist Auftraggeber, die KI ist die ausführende Agentin, auch wenn aus Informationssicht die KI über den Zugriff zu einem um Größenordnung höheren quantitativen Informationspool hat. Das qualitative Bewerten bleibt jedoch dem Prinzipal!

Das Eindringen von KI-Modulen in bisherige Standard-Software

Bin überrascht – ich hatte es mittelfristig erwartet, aber nicht jetzt. Eines der global bedeutendsten Programme für qualitative Inhaltsanalyse läuft seit Kurzem auf meinem Computer mit integrierter Künstlicher Intelligenz.

Zwar ist dies eine Testversion (Beta-Version), wovor ich mich üblicherweise hüte, denn zusammenbrechende Computer mit Datenverlust ist nicht meins. Aber alles mit KI ist derzeit heiß, also ausprobieren!

Interessant, dass selbst in der deutschen Version des Programms die KI nun AI (Artificial Intelligence) heißt, aber das spielt keine Rolle: The rat race is in full swing. Weltweit schießt die KI-Branche vorläufige Versionen raus und/oder kündigt die Integration von KI für Bürosoftware und Office-Anwendungen für die nächsten Monate an.

Wie schön, jedoch bedeutet das auch, dass diese AI-Programme beim Kunden reifen. Wie das oft der Fall in der IT-Branche ist: Die zahlenden Kunden verbessern durch ihre Beschwerden und Anregungen das Produkt.

Die von von mir hauptsächlich verwendete Qualitative Data Analysis-Software (QDA) ist Maxqda, wie unschwer meiner Homepage zu entnehmen ist. Wo und für welche Funktionen wird hier AI angeboten?

Das nämlich ist das Spannende an dieser Beta-Version; die bereits erkennbare Stärke von KI wird konsequent genutzt und gleichzeitig beinhart kanalisiert.

Das Grundprinzip eines derzeit gut funktionierenden Prompts (Frage und Detaillierungen an die KI) wird durchgehend realisiert: Erstens, die Aufforderung für einen Text steht am Anfang des Prompts; zweitens, die einengend-präzisierenden Zusatzinformationen kommen anschließend.

Die Umsetzung dieses Prinzips sieht bei Maxqda 2022.7.ß so aus:

- Die Funktion Subcodes vorschlagen: Das für die Daten entwickelte Codesystem – sei es deduktiv oder induktiv oder beides gemischt – stellt das zentrale Werkzeug einer qualitativen Inhaltsanalyse dar. Die Hauptcodes sollten beschrieben (definiert) und im Idealfall mit Ankerbeispielen versehen sein. Fordere nun die integrierte AI auf, zu einem definierten Hauptcode Subcodes vorzuschlagen, so ist dies für die AI aufgrund der klaren Vorgaben ein Leichtes, zentrale Subcodes vorzuschlagen.

- Die Funktion Codierte Segmente zusammenfassen: Ein Heimspiel für jede Text-AI! Codierte Text-Fundstellen (Segmente) werden zusammengefasst und in den zugeordneten Code-Kommentaren gespeichert. Die Profis geben noch an, in welchem Umfang die Zusammenfassung sein oder worauf besonders Wert gelegt werden soll. Dies bietet die zusätzliche Funktion Ergebnisse nach Wunsch anpassen.

- Die Funktion Ausgewählte Textpassagen zusammenfassen: Die markierten Textpassagen werden exzerpiert und direkt in ein Memo gespeichert. Diese scheinbare Allerwelts-Funktion könnte allerdings jede qualitative Inhaltsanalyse fördern. Denn das Verfassen von Memos hält spontane Gedanken und eventuell kreative Überlegungen zwischendurch fest. So wie es etwa in der die Grounded Theory angeraten und gefordert wird. Wodurch die Qualität der Memos berücksichtigenden Analyse sich verbessern sollte.

- Die Funktion Automatische Zusammenfassungen erstellen: Dies kann als nette Finger- und Eingangsübung angesehen werden. Qualitativen Ansprüchen an eine gediegene Inhaltsanalyse kann das aus wissenschaftlicher Sicht nicht gerecht werden. Der Kontext (Problemstellung, Forschungsfragen, Setting der Datenerhebungen etc. ) ist der AI nicht bekannt.

Für alle Funktionen gilt: Die Bachelor-, Master- und DoktorkandidatInnen sind gefragt, einzugreifen und KEINESFALLS das erste Ergebnis so stehen zu lassen.

21. Juni 2023

Humor von Chat-GPT

Aufforderung: Tell me a joke about writing an academic thesis

KI-Antwort: "Warum wurde der Doktorand ein Marathonläufer?

Weil er es leid war, eine Doktorarbeit zu schreiben – und die Freude erleben wollte, eine Ziellinie zu erreichen."

18. Juni 2023

KI wird ForscherInnen dazu bringen, den Forschungsweg offenzulegen.

Früher gaben Doktoranden nach drei oder vier Jahren des Recherchierens, Forschens und Schreibens eine reich gegliederte Arbeit mit einem mehrdutzendseitigen Literaturverzeichnis als Dissertation ab. Das Thema war in der Regel seriös und tiefschürfend aufbereitet worden, keine Frage.

Fehlende Problemstellung, grobe Zielangabe, die aus einer Wiederholung des Themas besteht, und nicht genau formulierte Forschungsfragen führten häufig zu mäandernder Darstellung und folglich mangelnder Stringenz.

Es entstanden mehrhundertseitige akademische Wälzer, die verschiedene Perspektiven des Themas lose zusammenhängend durchleuchtet hatten.

Man erfuhr, wie die rechtliche Seite in der Schweiz aussieht, die historische Situation in Österreich und die administrative Umsetzung in Deutschland. Immer dabei: ein Exkurs. Ein unpassendes Kapitel, was der Name schon anzeigt: Ex-Kurs, ein Synonym für ‚Abweichung, Vom-Wege-abgekommen-Sein ‘.

Das ist seit einigen Jahren weitgehend vorbei, abgesehen von Ausnahmen.

Es wird eine stringente lineare Argumentationsstruktur gefordert, beginnend mit der Problemstellung, dann

–> den abgeleiteten Forschungsfragen (und im quantitativen Fall präzisierten Hypothesen)

–> dem Forschungsdesign

–> dem Forschungsstand

–> den verwendeten Methoden

–> den Ergebnissen inklusive Schlussfolgerungen

–> der Diskussion, Limitation und Ausblick.

Jeder Schritt und die Reihenfolge sollten überzeugend begründet sein, um einen roten Faden erkennbar zu machen.

Dabei weiß jeder, dass Forschung anders verläuft: in un-zusammenhängenden Schüben und in wiederkehrenden Loops. Möglicherweise sogar von der Mitte aus gestartet – gleichsam vom zweiten Akt eines Theaterstücks: Hat die ForscherIn einen Zugang zu welchen Zielgruppen?

Dann bestimmt rekursiv (!) dieser empirische Zugang die nun nur mehr formal ersten Glieder der Argumentationskette mit Problemstellung, Forschungsfragen etc.

Es wird noch schlimmer, denn solche Arbeiten können brillant sein und neue Erkenntnisse liefern! Nur hat die erwartete und ewig gleiche formale Darstellung des fiktiv-idealisierten Ablaufs einen Fake-Aspekt: So ist es NICHT gelaufen. Dieser Fake-Aspekt stellt einen wunden Punkt in Wissenschaften dar, in Gebieten, die sich der Wirklichkeit und Wahrheit verpflichtet sehen.

Denn es gilt nicht nur für Statistik: Die Ergebnisse sind eng mit dem Weg ihrer Erzeugung verbunden. Doch der real gegangene Weg existiert offiziell nicht mehr.

Wie bei einer fixen Sightseeing-Tour für Städtetouristen werden vieltausendmal immer die selben Stationen abgeklappert. Was daneben oder dahinter liegt, weiß man nicht.

Aufschluss über den tatsächlichen Weg der Forschung (und damit zu den Ergebnissen) kann erreicht werden Protokollieren der Forschungabläufe: das Forschungsprotokoll. In einigen wenigen Fächern wie etwa der Ethnologie ist dies ein Muss.

In vielen Fächern wird das Protokollieren von Annahmen, Ideen und Zwischenergebnissen in Veranstaltungen zu wissenschaftlichen Methoden zwar erwähnt, doch umgesetzt wird es kaum. KI wird dies fundamental verändern.

Richtig, konventionell-lineare Forschungsgliederungen haben den Vorteil, wichtige Stationen der Forschung kurz und prägnant zu vermitteln. Allerdings werden KI-Chatbots den Unbedingtheitsanspruch solcher gekünstelten Gliederungen relativieren. Die oft entscheidende Reihenfolge der Forschungsstationen und Überlegungen sollte nicht mehr verschwiegen werden.

Das Instrument des Forschungsprotokolls könnte in Zukunft in jeder Phase den Einsatz aller genutzten Werkzeuge (Literaturquellen, KI-Chatbots etc.) belegen.

Auf diese Weise würde das fundamentale wissenschaftliche Gütekriterium der "intersubjektiven Nachvollziehbarkeit" in den Geistes-, Sozial- und Kulturwissenschaften voll zum Tragen kommen.

Großartig, ein Hoch der KI!

16. Juni 2023

Der Dialog mit Chat-GPT bringt's

Die Antworten von Chat-GPT sind nett, zeigen wenig Ecken und Kanten und lesen sich auf den ersten Blick überzeugend. Den Entwicklern hatten in der Ausgabe ein höfliches und allseits abgerundetes Verhalten verordnet.

Gleicht fast schon einem Smalltalk. Fast. 😊

Jedenfalls ist das für tiefgehendes und präzises Arbeiten im Rahmen eines Forschungsprojekts ungeeignet. Die universitären Betreuer und Gutachter werden diesen Stil relativ schnell erkennen und – völlig zu Recht – durchschauen.

Für einen angehenden Akademiker ist daher das Wichtigste nicht der Text der Erstantwort, sondern ein Klick auf den Button "Regenerate response" samt detaillierten Anforderungen wie "Nennen Sie mir die wichtigsten Quellen".

Auf diese nachbohrende Weise werden nicht nur interessantere Antworten generiert, sondern man erkennt rasch die Limitationen des Sprachmodells, nämlich worauf es nicht trainiert wurde, was es nicht in seinem Repertoire hat.

So führt ein Satz wie "Nennen Sie mir aktuelle Reviews/Übersichtsarbeiten zur Anwendung von Bayesschen Linearen Regression in der Medizin" nur zu einem allgemeinen Verweis auf Literaturrecherchen mittels Google Scholar oder der medizinischen Metadatenbank PubMed. Dies geschieht, nachdem Chat-GPT zuvor ganz nett und verständlich die Methode der Bayesschen Linearen Regression erklärt hat.

Chat-GPT ist eben ein Werkzeug, und wie jedes Werkzeug kann es manches sehr gut und anderes gar nicht. Mit einem Hammer werden Sie eben keine Sachertorte zerteilen können.

PS: Diesen Text hab ich von von der KI-Maschine auf grammatikalische Fehler lektorieren lassen. Wozu haben wir sie.

PPS: Meine strenge Lektorin hat dennoch zwei Fehler gefunden, quod erat demonstrandum. Sie sprach von Kauderwelsch, verrät es aber nicht. ;-)

13. Juni 2023

Schnatter-Roboter

Chatbots wie ChatGPT, Llama, Bard oder T5 schlagen weltweit in vielen gesellschaftlichen Bereichen wie Bomben ein. Experten erwarten durch den leichten und öffentlichen Zugang zur Künstlichen Intelligenz (KI) Veränderungen in der Gesellschaft, wie es historisch die Dampfmaschine oder das Automobil vollbrachte.

Da ist viel dran, dennoch schraubt Technik- und Fortschrittsglaube viele Erwartungen illusionär hoch.

Zuerst, was ist ein Chatbot? Bot zeigt als Abkürzung für Roboter auf einen elektronischen Algorithmus, der bestimmte Aufgaben durchführt.

Chat kommt aus dem Englischen und meint reden, plaudern, sich unterhalten, eventuell auch im Sinne von Gerüchte streuen1. Eine wortwurzelgetreue und sehr passende Übersetzung wäre 'Schnatterroboter'. Chatbots, also Programme, die plaudernd ein menschliches Gegenüber simulieren, beherrschen derzeit die Schlagzeilen.

Doch so neu sind sie nicht. Schon 1966 entwickelte der deutsch-amerikanische Informatiker Joseph Weizenbaum den Prototypen eines Chatbots, nämlich ELIZA. An sich wollte Weizenbaum mittels eines einfachen Programms nur aufzeigen, wie natürliche Sprache im Computer verarbeitet werden kann.

Eliza jedoch wurde ein Erfolg, viele nutzten es als virtuellen Psychotherapeuten. Weizenbaum warnte in der Folge über Jahrzehnte vor dem naiven Glauben an die Wahrheit aus dem Computer.

Denn Begriffe KI oder AI (Artificial Intelligence) enthalten in der Wortzusammensetzung bereits überzogene Ansprüche in Richtung intelligent, einsehen oder gar erkennen. In der Informatik werden diese Chatbots präziser als große Sprach-Modelle bezeichnet.

Mit riesigen Datensätzen und hoher Rechnerleistung durch spezielle KI-Chips (etwa von Nvidia) erzeugen Chatbots Texte, die wie von Menschenhand geschrieben wirken. Große Sprach-Modelle sind wortwörtlich das, was sie sind: large language models. Und sie liefern gemäß Input und Training einen Output. Das ist vorerst mal alles.

Ein bisschen Begriffsarbeit, und die Prozesse samt Ergebnissen werden deutlicher:

- Ein Modell ist etwas zutiefst Pragmatisches, also nicht mit der objektiven Wirklichkeit abgestimmt, sondern eine Selektion bestimmter Attribute oder Größen des Darzustellenden, die am nützlichen Gebrauch orientiert sind. Diese Selektion führt zur Vereinfachung bei gleichzeitiger Verzerrung komplexer Sachverhalte.

- Sprache besteht als komplexes Zeichensysteme zur Kommunikation, welche nur begrenzt logischen Normen unterworfen ist. Neben sachinhaltlichen Funktionen zählen sozialpsychologische und soziale.

- Groß bezeichnet eines spezifische Qualität, welche durch schiere Quantität erzeugt wird. Groß war etymologisch gesehen ursprünglich ein Wort für das Grobkörnige, nun auch „in Ausdehnung [nach irgendeiner Richtung] oder Umfang den Durchschnitt oder einen Vergleichswert übertreffend“2.

Die genannten Modelle werden auf Basis der Inhalte unzähliger Web-Sites (eben auf der Basis des Großen) trainiert. Das können Inhalte von strukturierten Datenbanken wie Wikidata sein, es können Patentdatenbanken, aber auch private Blogs mit nicht immer seriösen Ansprüchen sein.

Die geheim gehaltenen Algorithmen bauen zum Schluss und jetzt erst im Abfragefenster sichtbar im Themenrahmen sukzessive Wort für Wort und Satz für Satz gemäß linguistischen Wahrscheinlichkeitsvektoren auf.

Was kommt heraus? Ein schriftlich eleganter und flüssig aufgebauter Essay (wortwörtlich ein ‚Versuch‘), der Themen- und Aspektspezifisches bietet. Wie von Geisterhand schreibt der Computer eine Geschichte, einen Versuch, auf der Grundlage von Konstruiertem, kombiniert mit Wahrscheinlichem und Falschem.

Selten werden Originalquellen angegeben, wie auch, wenn das Modell auf unzählbaren Quellen basiert. Systematische Verzerrungen und Fehlinformation können eingebaut sein. Diese systematischen Verzerrungen sind weder auf den ersten noch auf den zweiten Blick erkennbar. Wie bei Gerüchten entstehen Entstellungen, Verfälschungen und Fehlinformationen. Diese Zerrbilder zeigen sich allerdings in einer wohlaufgebauten und verführerischen Sprache.

Was heißt Verzerrung, im wissenschaftlichen Jargon: der Bias?

Ein Beispiel soll dies verdeutlichen. Angenommen, es wird gezielt ein konkretes Thema in einem bestimmten Bereich abgefragt. Nehmen wir den großen Bereich „menschliche Gemeinschaft“3. Hier dominiert Religion. Völlig befremdlich aus heutiger Sicht. Im Mittelalter in Europa wäre eine gewisse Berechtigung dafür gewesen, aber auch jetzt, und wie war bzw. ist es weltweit?

Doch es wird noch schräger: Innerhalb Religion sind von den 20 Top-Sites 16 christlich! Verzerrter geht es kaum. Weder kann der Begriff Gemeinschaft global auf Religion beschränkt sein, noch Religion wiederum auf das Christliche. Die Bühne, auf welcher die Chatbots ihre Zauberkunststücke aufführen, könnte zumindest hier nicht ir-realer sein.

1 Chambers. Dictionary of Etymology, 2008, S. 162

2 Duden. Deutsches Universalwörterbuch 8. Auflage. 2015, S. 758

3 Entnommen aus Schaul, K/Chen, S. & Tiku, N. (April 19, 2023). Inside the secret list of websites that make AI like ChatGPT sound smart. The Washington Post.

6. Juni 2023

Wie Hochschulen mit der KI-Revolution umgehen könnten

Wie ein Tsunami dringen Chatbots in den tertiären Bildungsbereich ein. Selbst Studierende des ersten Semesters haben mit wenigen Klicks einen Zugang zu einem „verarbeiteten Wissen“ durch Chat-GPT und Schwester-Textprogramme.

Derzeit (Juni 2023) reagieren Unis, Fachhochschulen und akademische Lehrgänge kaum darauf, wie das bei großen Organisationen der Fall ist und auch sein muss.

Sie sind Riesentanker, die selbst für kleine Abweichungen vom Kurs viel Zeit und viele zwischenzeitlich gefahrene Kilometer benötigen. In den Seminaren wird vielleicht gesagt, dass Plagiatsprogramme solchen ‚Tricks‘ auf die Spur kommen.

Nur, es funktioniert nicht.

Selbst die besten derzeitigen Plagiats-Entdeckungsprogramme wie Turnitin können nur Wahrscheinlichkeiten angeben. Zahlreich durchgeführte Tests mit tatsächlich von Menschen geschriebenen Essays zeigen, dass einige (wenn zugegebenermaßen wenige Essays) falsch als von der KI geschrieben angeprangert werden.

Selbst die amerikanische Unabhängigkeitserklärung aus 1776 mit Thomas Jefferson als Hauptautor wird zu 99,9% als KI-geschrieben angesehen (1).

Zuverlässig und als seriöse Bildungsorganisation sich darauf zu verlassen, geht daher nicht. Die Ergebnisse sind zur Bewertung studentischer Arbeiten nicht geeignet. Pauschalverbote wären kontraproduktiv.

Mögliche Strategien eines Miteinanderlebens von Institution Hochschule und KI wären:

- Es ist jetzt schon möglich, dass zwei oder mehr Personen eine wissenschaftliche Arbeit (meist eine Dissertation) gemeinsam erarbeiten. Dies wird anerkannt, sofern ersichtlich ist, wer was verfasst hat. Dies könnte auch für den Einsatz von KI verwendet werden. Der Einsatz von KI muss offengelegt werden – entweder jeweils gekennzeichnet innerhalb des Haupttextes der Arbeit oder im Anhang. KI wäre damit eine herausgehobene Super-Quelle des Literaturverzeichnisses.

- Die Dokumentation und Qualität des individuellen Studienverlaufs wird wichtiger. Haben bis vor Kurzem Studierende inkonsistente Hausarbeiten mit groben Rechtschreibfehlern abgegeben und glänzen nun mit geschliffenen Formulierungen, so wäre dies näher zu prüfen. Eine solche Vorgehensweise hätte überdies den Vorteil, dass sich Hochschulen von einer in einigen Fächern bestehenden Massenabfertigung verabschieden.

Hurra, die direkte und persönliche Betreuung wäre wieder an der Tagesordnung. Genauso wie es ab dem 11. Jahrhundert, der Gründung von europäischen Universitäten der Fall war: Vortragende/Magistri und Studierende waren eine überschaubare Lern- und WissensGEMEINSCHAFT, eben eine universitas !

- Die Bedeutung schriftlicher Arbeiten wie Haus- oder Seminararbeiten wird sinken. Die Bedeutung mündlicher Prüfungen wird steigen. Dies führt in ein Dilemma, denn es impliziert einen deutlich höheren Ressourcen-Aufwand. Etwas, das die Hochschulen aus budgetären Gründen kaum stemmen können.

- Die Einführung von Hybrid-Prüfungen: Mündliche und schriftliche Prüfungen werden kombiniert. Etwa durch eine Acht-Stunden-Klausur, in welcher nur ein Laptop mit Internetanschluss erlaubt ist. Am Beginn wird eine Problemstellung genannt wird und die Studierenden nutzen KI-Programme zusätzlich zu ihrem inhaltlichen und methodischen Wissen für bestimmte Teil-Aufgaben.

Es ist leicht, jeden dieser Schritte elektronisch zu dokumentieren und mit dem Endergebnis zu vergleichen. Die Studierenden könnten dann die – auch bisher geforderte – zentrale Einschätzung von Quellen und des Vermögens, sie entsprechend zu verarbeiten, zeigen. Womit ein seriöser Transfer bei der Bearbeitung der Probleme oder des vorgegebenen Themas gewährleistet wird.

Bisherige Bildungsziele werden rascher und tiefergehend erreicht. Verschwörungstheoretischem Schwurbeln, das auf simplen und nicht überprüften Argumenten beruht, wird das Wasser abgegraben. Da KI aus dem Leben in allernächster Zukunft nicht mehr wegzudenken sein wird, entspräche das einem oft geforderten Anspruch an tertiäre Bildungsinstitutionen, Praxis- und Gesellschaftsaspekte schwerpunktmäßig aufzunehmen.

Was auch immer sein wird: Der Arbeitsmarkt der nahen Zukunft wird einen versierten Umgang mit KI voraussetzen!

(1) Agarwala, A. (7. Juni 2023). Diesen Text hat eine KI geschrieben. Behauptet eine KI. Aber hat sie auch recht? Wissen. Die Zeit Nr. 25, S. 29

30. Mai 2023

KI und das Verfassen von wissenschaftlichen Arbeiten

Mit großer Wucht durchpflügen leicht zugängliche Künstliche-Intelligenz-Systeme wie Chat-GPT das weite Feld des Erstellens von Seminar-, Bachelor- und Masterarbeiten.

Im ersten Moment scheint es, als bliebe kein Stein auf dem anderen. Bei näherer Beschäftigung wird klar, dass diese KI-Systeme zwar einem Werkzeug mit neuer Qualität entsprechen, aber der Werkzeugcharakter dennoch bestehen bleibt. Um drei Punkte herauszuheben:

1. Allein, wie Prompt und Frage formuliert sind, zeigt, dass vom Nutzer des KI-Systems ein ähnliches Know-how benötigt wird wie in der Recherche in der Fachliteratur mit Keywords. Abweichende Formulierungen erzeugen andere Ergebnisse.

2. Inhaltlich sind die Ergebnisse nun noch viel intensiver zu prüfen als die Quellen bisher schon: Check - ReCheck - DoubleCheck. Die Einschätzung von Quellen auf Seriosität war eine geforderte Fähigkeit, die allerdings im Begutachtungsverfahren nicht immer ein großes Gewicht hatte.

Damit ist es nun vorbei. Die Quellen-Untersuchung und -Bewertung wird ein entscheidendes Kriterium werden für eine gehaltvolle wissenschaftliche Arbeit.

3. Das 'Gehirnschmalz' der VerfasserInnen wird sich auf das Eigentliche der Erkenntnisarbeit konzentrieren müssen, also auf jene Bereiche, welche die KI (derzeit noch nicht und eventuell für eine längere Zeit) nicht kann: Forschungsdesign und Umsetzung im wissenschaftsoziologischen und -inhaltlichen Kontext, argumentative Stringenz/roter Faden, Tiefe, Berücksichtigung psychologischer und sozialer Auswirkungen, etc.

Es ist zu vermuten, dass die Schere zwischen souveränen, die Methoden anwendenden, und lässigen, sich eher ans Formale haltenden Studierenden noch weiter aufgehen wird.

30. Mai 2023